In diesem Kurs lernen Sie verschiedene Algorithmen kennen, die auf der Grundlage von Versuch und Irrtum mit der Umwelt nahezu optimale Strategien erlernen können - Lernen aus der eigenen Erfahrung des Agenten. Das Lernen aus eigener Erfahrung ist bemerkenswert, weil es keine Vorkenntnisse über die Dynamik der Umgebung erfordert und dennoch ein optimales Verhalten erreichen kann. Wir werden intuitiv einfache, aber leistungsstarke Monte-Carlo-Methoden und Methoden des Lernens mit zeitlichen Differenzen einschließlich Q-Lernen behandeln. Zum Abschluss dieses Kurses werden wir untersuchen, wie wir das Beste aus beiden Welten erhalten können: Algorithmen, die modellbasierte Planung (ähnlich der dynamischen Programmierung) und Temporal-Differenzen-Updates kombinieren können, um das Lernen radikal zu beschleunigen. Am Ende dieses Kurses werden Sie in der Lage sein: - Temporal-Differenzen-Lernen und Monte Carlo als zwei Strategien zur Schätzung von Wertfunktionen aus gesampelter Erfahrung zu verstehen - die Bedeutung der Exploration zu verstehen, wenn man gesampelte Erfahrung anstelle von Sweeps der dynamischen Programmierung innerhalb eines Modells verwendet - die Verbindungen zwischen Monte Carlo und dynamischer Programmierung und TD zu verstehen.

Methoden zum Lernen anhand von Beispielen

Methoden zum Lernen anhand von Beispielen

Dieser Kurs ist Teil von Spezialisierung für Reinforcement Learning

Dozenten: Martha White

37.805 bereits angemeldet

Bei enthalten

1,254 reviews

Empfohlene Erfahrung

Kompetenzen, die Sie erwerben

- Kategorie: Stichproben (Statistik)

- Kategorie: Simulationen

- Kategorie: Wahrscheinlichkeitsverteilung

- Kategorie: Algorithmen

- Kategorie: Reinforcement Learning

- Kategorie: Künstliche Intelligenz und Maschinelles Lernen (KI/ML)

- Kategorie: Maschinelles Lernen

- Kategorie: Algorithmen für maschinelles Lernen

Wichtige Details

Zu Ihrem LinkedIn-Profil hinzufügen

5 Aufgaben

Erfahren Sie, wie Mitarbeiter führender Unternehmen gefragte Kompetenzen erwerben.

Erweitern Sie Ihre Fachkenntnisse

- Lernen Sie neue Konzepte von Branchenexperten

- Gewinnen Sie ein Grundverständnis bestimmter Themen oder Tools

- Erwerben Sie berufsrelevante Kompetenzen durch praktische Projekte

- Erwerben Sie ein Berufszertifikat zur Vorlage

In diesem Kurs gibt es 5 Module

Willkommen zum zweiten Kurs der Reinforcement Learning Specialization: Sample-Based Learning Methods, der von der University of Alberta, Onlea und Coursera angeboten wird. In diesem Modul zur Vorbereitung auf den Kurs lernen Sie Ihre Dozenten kennen und erhalten einen Vorgeschmack darauf, was der Kurs für Sie bereithält. Stellen Sie sich Ihren Mitschülern im Abschnitt "Meet and Greet" vor!

Das ist alles enthalten

2 Videos2 Lektüren1 Diskussionsthema

In dieser Woche werden Sie lernen, wie man Wertfunktionen und optimale Strategien schätzt, indem man nur Stichproben aus der Umgebung verwendet. Dieses Modul ist unser erster Schritt in Richtung inkrementeller Lernmethoden, die aus der Interaktion des Agenten mit der Welt lernen und nicht aus einem Modell der Welt. Sie werden Methoden zur Vorhersage und Kontrolle kennenlernen, die auf Monte-Carlo-Methoden beruhen, d.h. auf Methoden, die auf Stichproben basieren. Sie werden auch erneut mit dem Explorationsproblem konfrontiert, allerdings allgemeiner im RL, über Banditen hinaus.

Das ist alles enthalten

11 Videos3 Lektüren1 Aufgabe1 Programmieraufgabe1 Diskussionsthema

In dieser Woche lernen Sie eines der grundlegendsten Konzepte des Verstärkungslernens kennen: das temporale Differenzlernen (TD). TD-Lernen kombiniert einige der Eigenschaften von Monte-Carlo-Methoden und Dynamischer Programmierung (DP). TD-Methoden ähneln den Monte-Carlo-Methoden insofern, als sie aus der Interaktion des Agenten mit der Welt lernen können und keine Kenntnis des Modells erfordern. TD-Methoden ähneln den DP-Methoden insofern, als sie Bootstrap verwenden und somit online lernen können - Sie müssen also nicht bis zum Ende einer Episode warten. Sie werden sehen, wie TD aufgrund des Bootstrapping effizienter lernen kann als Monte Carlo. In diesem Modul konzentrieren wir uns zunächst auf TD für die Vorhersage und besprechen TD für die Kontrolle im nächsten Modul. Diese Woche werden Sie TD implementieren, um die Wertfunktion für eine festgelegte Strategie in einem simulierten Bereich zu schätzen.

Das ist alles enthalten

6 Videos2 Lektüren1 Aufgabe1 Programmieraufgabe1 Diskussionsthema

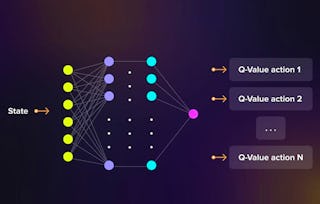

In dieser Woche lernen Sie die Verwendung von temporalem Differenzlernen für die Kontrolle als verallgemeinerte Strategie für die Iteration von Richtlinien kennen. Sie werden drei verschiedene Algorithmen kennenlernen, die auf Bootstrapping und Bellman-Gleichungen für die Kontrolle basieren: Sarsa, Q-learning und Expected Sarsa. Sie werden einige der Unterschiede zwischen den Methoden für On-Policy- und Off-Policy-Kontrolle erkennen und dass Expected Sarsa ein einheitlicher Algorithmus für beide ist. Sie werden Expected Sarsa und Q-learning auf Cliff World implementieren.

Das ist alles enthalten

9 Videos3 Lektüren1 Aufgabe1 Programmieraufgabe1 Diskussionsthema

Bisher dachten Sie vielleicht, dass Lernen mit und ohne Modell zwei unterschiedliche und in gewisser Weise konkurrierende Strategien sind: Planung mit Dynamischer Programmierung gegenüber stichprobenbasiertem Lernen mit TD-Methoden. In dieser Woche vereinen wir diese beiden Strategien mit der Dyna-Architektur. Sie werden lernen, wie man das Modell aus Daten schätzt und dieses Modell dann verwendet, um hypothetische Erfahrungen zu generieren (ein bisschen wie Träumen), um die Effizienz von Stichproben im Vergleich zu stichprobenbasierten Methoden wie Q-Learning drastisch zu verbessern. Darüber hinaus lernen Sie, wie man Lernsysteme entwickelt, die gegenüber ungenauen Modellen robust sind.

Das ist alles enthalten

11 Videos4 Lektüren2 Aufgaben1 Programmieraufgabe1 Diskussionsthema

Erwerben Sie ein Karrierezertifikat.

Fügen Sie dieses Zeugnis Ihrem LinkedIn-Profil, Lebenslauf oder CV hinzu. Teilen Sie sie in Social Media und in Ihrer Leistungsbeurteilung.

Dozenten

Mehr von Maschinelles Lernen entdecken

Status: Vorschau

Status: VorschauColumbia University

Status: Vorschau

Status: VorschauNortheastern University

Status: Vorschau

Status: VorschauNortheastern University

Status: Vorschau

Status: VorschauSimplilearn

Warum entscheiden sich Menschen für Coursera für ihre Karriere?

Felipe M.

Jennifer J.

Larry W.

Chaitanya A.

Bewertungen von Lernenden

- 5 stars

82,31 %

- 4 stars

13,22 %

- 3 stars

2,78 %

- 2 stars

0,63 %

- 1 star

1,03 %

Zeigt 3 von 1254 an

Geprüft am 13. März 2022

The videos are very clear and do a good job explaining the material from the textbook. The assignments are relevant and just right in terms of length and difficulty.

Geprüft am 27. Feb. 2020

Itwasgoodinsubstane but there is plenty of issues with the automated grader. you spend most time dealing with the letter not on actual learning of the matter.

Geprüft am 9. Jan. 2020

Really great resource to follow along the RL Book. IMP Suggestion: Do not skip the reading assignments, they are really helpful and following the videos and assignments becomes easy.

Neue Karrieremöglichkeiten mit Coursera Plus

Unbegrenzter Zugang zu 10,000+ Weltklasse-Kursen, praktischen Projekten und berufsqualifizierenden Zertifikatsprogrammen - alles in Ihrem Abonnement enthalten

Bringen Sie Ihre Karriere mit einem Online-Abschluss voran.

Erwerben Sie einen Abschluss von erstklassigen Universitäten – 100 % online

Schließen Sie sich mehr als 3.400 Unternehmen in aller Welt an, die sich für Coursera for Business entschieden haben.

Schulen Sie Ihre Mitarbeiter*innen, um sich in der digitalen Wirtschaft zu behaupten.

Häufig gestellte Fragen

Um Zugang zu den Kursmaterialien und Aufgaben zu erhalten und um ein Zertifikat zu erwerben, müssen Sie die Zertifikatserfahrung erwerben, wenn Sie sich für einen Kurs anmelden. Sie können stattdessen eine kostenlose Testversion ausprobieren oder finanzielle Unterstützung beantragen. Der Kurs kann stattdessen die Option "Vollständiger Kurs, kein Zertifikat" anbieten. Mit dieser Option können Sie alle Kursmaterialien einsehen, die erforderlichen Bewertungen abgeben und eine Abschlussnote erhalten. Dies bedeutet auch, dass Sie kein Zertifikat erwerben können.

Wenn Sie sich für den Kurs einschreiben, erhalten Sie Zugang zu allen Kursen der Spezialisierung, und Sie erhalten ein Zertifikat, wenn Sie die Arbeit abgeschlossen haben. Ihr elektronisches Zertifikat wird Ihrer Seite "Leistungen" hinzugefügt - von dort aus können Sie Ihr Zertifikat ausdrucken oder Ihrem LinkedIn-Profil hinzufügen.

Ja. Für ausgewählte Lernprogramme können Sie eine finanzielle Unterstützung oder ein Stipendium beantragen, wenn Sie die Anmeldungsgebühr nicht aufbringen können. Wenn für das von Ihnen gewählte Lernprogramm eine finanzielle Unterstützung oder ein Stipendium verfügbar ist, finden Sie auf der Beschreibungsseite einen Link zur Beantragung.

Weitere Fragen

Finanzielle Unterstützung verfügbar,